Ecco perché NON esiste la “Google Formula”

Da quando mi interesso di SEO, le cose sono cambiate moltissimo. Nell’arco di pochi anni la SEO è diventata terribilmente… “complicata”. Qualcuno direbbe che le cose sono evolute in peggio; io preferisco dire in meglio (dipende ovviamente dai punti di vista 🙂 ). Di certo la SEO del 2015 NON è nemmeno lontanamente simile a quella di 15, 10 o anche solo 5 anni fa. Ma partiamo con una brevissima cronistoria, in base ai miei ricordi degli ultimi 3-4 lustri.

Da Altavista a Google

La SEO pre-Google, quella del vecchio millennio, era basata sulla semplice presenza della parola chiave all’interno della pagina. I SEO di allora capirono in fretta il trucchetto, e iniziarono ad infarcire le pagine di centinaia e centinaia di keyword identiche, per salire in vetta alle SERP: nacque così l’orrenda pratica del keyword stuffing, che sopravvive ancora oggi nei footer di qualche vecchio sito web.

Ma siccome vedere un muro di parole uguali dentro una pagina faceva abbastanza schifo, i SEO più scaltri inventarono la tecnica di scriverle dello stesso colore dello sfondo. Erano le mitiche keyword “scritte in bianco, su sfondo bianco”: l’utente non le vedeva, ma i motori di allora, un po’ stupidotti, le leggevano eccome… e posizionavano in vetta queste pagine orrende.

Terminata l’era di Altavista & Co., iniziò quella di Google. La differenza di Google rispetto agli altri motori, nonché la sua forza, fu quella di basarsi su quantità e qualità di link per capire quanto fosse importante una pagina: più link (di qualità) riceveva più era importante, più era importante e più era meritevole di posizionarsi meglio delle altre.

Questa felice intuizione permise a Google di lasciarsi indietro in breve tempo i rivali, che utilizzavano algoritmi “primitivi” e che nel frattempo avevano completamente perso la bussola, evolvendo (anzi, involvendo) da puri motori di ricerca ad un mix fra directory e “portali” (termine di gran moda alla fine del secolo scorso).

Link di Qualità, o Link in Quantità?

Ma la storia del “link di qualità”, almeno all’inizio, era una gran leggenda. Per posizionarsi bene poteva bastare un solo link con un testo ancorato secco, da una pagina con un PageRank elevato, anche se completamente off-topic. Tradotto: se un sito .edu (scuola/università nordamericana) o .gov (sito governativo USA) ti linkava con l’àncora [seo], avevi buone possibilità di volare in vetta a quella SERP di Google, anche la pagina sulla quale era posto il link non aveva nulla a che fare con il posizionamento sui motori di ricerca, anche se era scritta in una lingua diversa da quella della tua pagina.

E si poteva anche lavorare sulla quantità: centinaia o migliaia di link spazzatura, da directory o siti di social bookmarking (prima) e di article marketing (poi), potevano avere effetti miracolosi. Dal Penguin in poi (Aprile 2012), questi fenomeni sono stati di molto ridimensionati, se non azzerati del tutto: se in alcuni casi il link off-topic – ma da un sito con forte trust – può ancora oggi darti una spinta, i link da siti di pessima qualità sono invece diventati estremamente pericolosi e a rischio di penalizzazione.

Semantica, Knowledge Graph e Hummingbird

A Marzo del 2012 Google annunciò di aver imboccato la strada della semantic search, e 2 mesi dopo presentò Knowledge Graph. Alla fine dell’estate 2013 fu la volta di Hummingbird: da allora il motore non si focalizza più sulle singole parole chiave, ma cerca di comprendere il completo significato della query, fornendo risposte di conseguenza. “Things, not strings” è il motto coniato da Amit Singhal, che identifica questa evoluzione. Si inizia insomma a parlare pesantemente di “SEO semantica“.

Ma Google non è Comunque una Macchina?

Sì, ma sta facendo passi di gigante nel campo dell’Artificial Intelligence e Machine Learning, come puoi facilmente leggere sul sito Research at Google. Il Google di oggi è sempre più difficile da “ingannare”, o perlomeno funzionano sempre meno le logiche da “formuletta magica” che capita ancora di veder girare sul web. Quindi il cercare di applicare uno schema sempre uguale per posizionare enne pagine di un sito web (o enne siti diversi fra loro) rischia di essere un lavoro totalmente inutile, se non addirittura deleterio (eccezioni a parte, ovviamente 🙂 ).

Google e le Leggende SEO Metropolitane

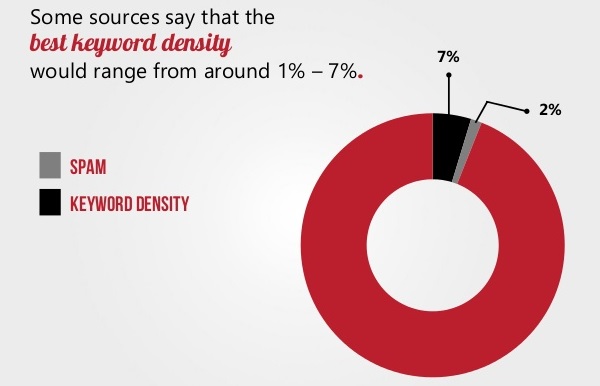

Un classico, un sempreverde che è sopravvissuto a diversi lustri ed è assai duro a morire è il concetto di keyword density: in pratica, c’è ancora oggi chi afferma che se la parola chiave che vuoi posizionare è presente sulla tua pagina in una determinata percentuale, allora Google ti premierà.

Questa cosa deriva probabilmente dai tempi di Altavista (come indicato all’inizio di questo post), e/o dalla cattiva interpretazione di una vecchissima dichiarazione di Google che suonava più o meno così:

Oggi i nostri algoritmi si basano su più di 200 segnali univoci, come la frequenza con cui i termini di ricerca sono presenti sulla pagina…

Ebbene, stare nel 2015 a misurare la keyword density col bilancino di precisione non ha alcun senso. Lo ribadisco nuovamente: ci sono cose che, se applicate in modo sistematico, rischiano di essere facilmente individuate e quindi penalizzate da Google. Pensaci bene: un algoritmo fa molto in fretta ad individuare un pattern, una impronta, un comportamento ripetuto.

Se a questo aggiungi che l’algoritmo di Google è sempre più intelligente, e si avvale anche di quality rater umani, ecco che il cerchio si chiude. Vuoi un piccolo esempio? Eccotelo. Un SEO di mia conoscenza, è stato penalizzato anni fa per un comportamento identificato da Google come spammoso. Il personaggio in questione aveva un blog su Blogger/Blogspot, che in quel periodo non permetteva di schedulare i post ad una determinata ora del giorno.

Lui, però, scriveva e pubblicava un post tutti i santi giorni, dopocena, “forzando” a mano l’ora di pubblicazione, mettendola (per sua abitudine) sempre uguale. In pratica aveva un blog con centinaia di post, tutti pubblicati alla stessa identica ora. E Google ha quindi “pensato” che non poteva essere una persona a scrivere e pubblicare i contenuti sempre alla stessa ora, ma una macchina… e quindi lo ha penalizzato.

Conclusione

La tesi che voglio esprimere con questo post NON è quella che non esistono regole nella SEO. Le regole esistono, ma NON sono quelle riconducibili alla percentuale di parole chiave incluse nel testo, al semaforino verde di Yoast, o ad altre cose da applicare in modo sistematico come una ricetta. Personalmente credo che verranno sempre più premiate cose difficili da creare velocemente, automaticamente o in serie. In altre parole, un sito web NON diventa punto di riferimento nel suo settore dal giorno alla notte.

Un articolo di enorme valore NON si scrive in 5 minuti. Per ottenere tanti lettori/clienti fidelizzati ci vuole un sacco di tempo (e spesso anche un sacco di soldi). Tempo, fatica, investimenti. Ecco, io credo che questa è la strada che dovranno imboccare non solo i SEO, ma tutti quelli che sul web vogliono campare a lungo. E questo percorso non è scritto dentro una “Google Formula”.