Meno Click suoi tuoi Risultati in Google, meno Posizionamento!

Sicuramente saprai che puoi danneggiare il posizionamento di un sito web a suon di link di pessima qualità. Ma secondo Bartosz Góralewicz, noto SEO polacco, esiste anche quella che lui chiama Linkless Negative SEO, ovvero la possibilità di far perdere posizioni ad una pagina su Google SENZA utilizzare link spammosi. Bartosz ha notato un problema di visibilità su 2 siti di suoi clienti, problema non causato dai soliti Panda e Penguin. I 2 siti erano più “sani” dei loro rispettivi concorrenti, eppure perdevano visibilità su Google. Non era questione di link, di citazioni, o di altri elementi on-page. Quali erano dunque la cause?

Crawling “Pesante” (e Sospetto)

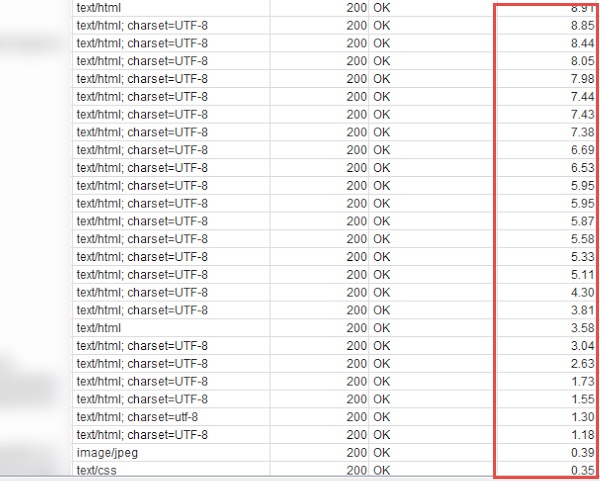

Il primo sito mostrava problemi di carico sul server, cosa che si verificava soprattutto alle prime ore del mattino (fra le 2 e le 5). La causa era probabilmente una scansione molto pesante delle pagine, probabilmente lanciata da qualche concorrente, che portava a tempi di risposta molto elevati:

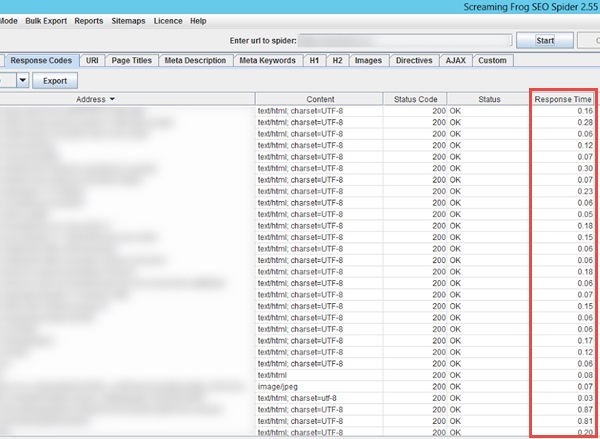

Normalmente, infatti, il sito ha un response time decisamente più basso:

Se è quindi vero il fatto che la velocità – pardon, l’eccessiva lentezza – è considerata da Google come un fattore di ranking, ecco svelato il mistero della misteriosa perdita di posizioni.

Nessun Click dalle SERP di Google

Il secondo sito ha invece subito quello che potremmo chiamare un click through attack su Google, sulle parole chiave principali legate al brand. In pratica, sembrava che un CTR bot fosse stato programmato da qualche concorrente per fare delle ricerche su Google per determinate parole chiave, e cliccare poi sui risultati delle ricerche. Ma senza MAI cliccare il sito del cliente di Góralewicz.

Bartosz dice di aver risolto questo problema utilizzando a sua volta un em>CTR bot, programmato per cliccare sul suo cliente: dopo 3-4 settimane sembra che il sito si sia (lentamente) ripreso. Questa è ovviamente solo una sua ipotesi: il dubbio che il calo fosse stato generato da altre cause è forte, e molti suoi colleghi non si sono trovati d’accordo sulle sue teorie. E allora il nostro SEO polacco ha deciso di fare un test direttamente sul suo sito.

Test di Negative SEO… SENZA Link!

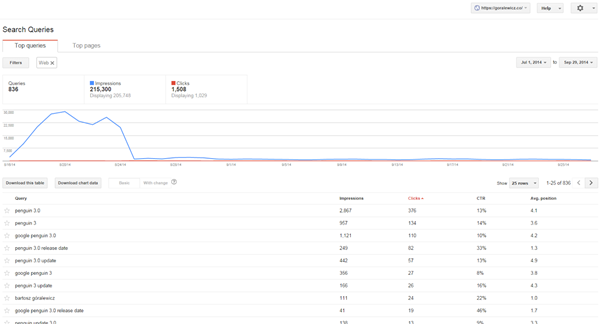

Il blog di Góralewicz ha circa 12 mesi, e non ha mai fatto azioni di link building: il pratica, il sito si è posizionato in un modo del tutto naturale. Bartosz ha quindi scelto una parola chiave con cui era posizionato molto bene, grazie a link naturali di alta qualità. Ha quindi creato un bot con lo scopo di effettuare query per [penguin 3.0] (questa la keyword selezionata), e poi cliccare a caso sui risultati della SERP. Su tutti, TRANNE che sul suo. Ed ecco il risultato,

confermato anche dal pannello di Searchmetrics:

Góralewicz assicura di aver monitorato accuratamente i concorrenti nella stessa SERP, per capire se il suo brusco calo fosse dovuto ai loro “meriti”, ma su quel fronte non ha trovato nulla in grado da poter giustificare una caduta così repentina. E quindi ha coniato questo nuovo termine:

Linkless Negative SEO

La user experience è un forte segnale per Google, cosa confermata anche dagli ultimi Ranking Factors – Rank Correlation di Searchmetrics. Yandex dice di non considerare più i link come fattore di ranking, per quanto riguarda le query di carattere commerciale. Matt Cutts ha invece affermato che Google ha testato internamente una versione del motore che non faceva uso di link per determinare il posizionamento delle pagine, ma dal test è emersa una qualità dei risultati davvero pessima. Eppure, secondo Bartosz, anche Google potrebbe non basarsi (principalmente) sui link nel suo algoritmo di ranking. O perlomeno potrebbe dare oggi molto peso ad altri fattori, come il tasso di click nelle SERP del motore di ricerca.

Conclusione

Se fosse confermata, la Linkless Negative SEO – ovvero la Negative SEO che NON fa uso di link – sarebbe qualcosa di estremamente insidioso e critico: un SEO con medie competenze è infatti in grado di individuare piuttosto in fretta e piuttosto bene i “link spazzatura”, ed effettuare di conseguenza la procedura di disavow senza troppe difficoltà. Ma capire che una pagina scende perché ad alcune ore della notte il server viene “rallentato”, o peggio perché riceve pochi click nelle SERP di Google (mentre i suoi concorrenti ne ricevono parecchi, anche se più o meno artificiali), non è davvero cosa semplice e alla portata di tutti. Siamo entrati in una nuova era della Negative SEO? O sono solo SEO-paranoie?