L’espressione del volto influenzerà i risultati di Google?

Il post odierno è un tentativo di “unire i puntini”, per cercare di capire se certe cose che appaiono oggi assurde (o quantomeno strane) potranno davvero condizionare in futuro il nostro rapporto con Google (o, se preferisci, il suo rapporto con noi).

Punto 1.

Se partiamo da Hummingbird, e proseguiamo poi con RankBrain e D-Wave, notiamo che Google sta facendo un enorme sforzo per “umanizzare” macchine e algoritmi, per renderli più intelligenti, inteso nel senso più arcaico del termine: il termine intelligere pare infatti che risalga a inter + legere, quindi sapere scegliere, distinguere, comprendere, o “leggere dentro” (come mi piace dire).

Punto 2.

Se non te ne fossi ancora accorto, siamo arrivati al punto in cui le ricerche effettuate su Google via mobile han superato quelle via desktop, e il 20% di query viene effettuata via voce (la ricerca vocale è una delle cose che ha più influenzato e cambiato il “modo di comprendere” del motore di ricerca). E se ti interessi almeno un po’ di SEO, sai anche che Google ha spinto molto (e ancora sta spingendo) affinché tutti i siti web siano al più presto mobile-friendly, ovvero adatti per tutti i dispositivi ma in particolare per quelli mobili.

Punto 3.

Durante l’I/O 2016 di qualche giorno fa, Google ha annunciato una serie di oggetti e applicazioni con le quali l’utente potrà interagire in modo molto più “umano”: Google Now verrà potenziato diventando un vero e proprio “Google Assistant”, Google Allo (nuova app di messaggistica istantanea) include un chat bot molto evoluto e infine in autunno è previsto l’arrivo di Daydream, una piattaforma che promette “un’alta qualità mobile per la realtà virtuale”. Sundar Pichai ha chiuso il keynote parlando proprio della crescente importanza che machine learning e intelligenza artificiale hanno e avranno sempre più per Google.

Hai unito i puntini? Bene.

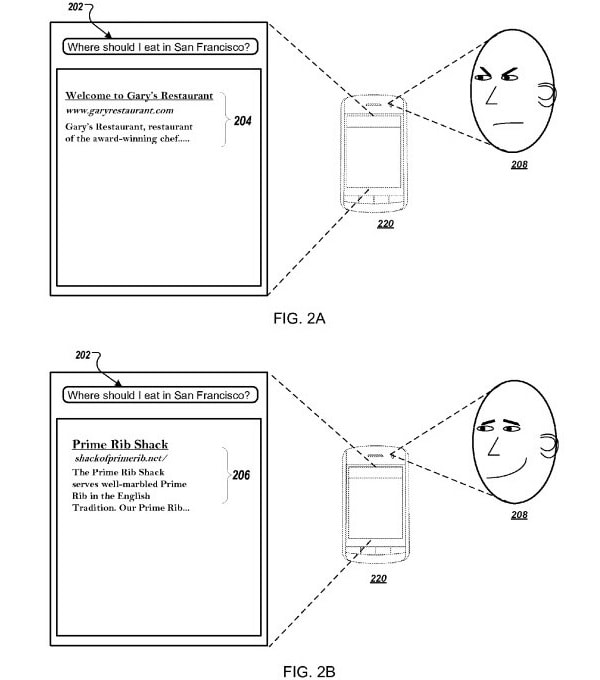

Ora che lo hai fatto, vedrai che non ti suonerà poi così assurdo il brevetto “Ranking Query Results Using Biometric Parameters”, venuto alla ribalta il mese scorso al seguito di un post di Bill Slawski. Nel brevetto Google accenna ad una tecnologia che potrebbe modificare scoring e ranking dei risultati delle query utilizzando indicatori biometrici correlati alla soddisfazione dell’utente o all’engagement negativo. In parole più semplici: Google potrebbe cercare di capire la tua reazione ad una query osservando l’espressione del tuo volto tramite la fotocamera presente sullo smartphone, osservando cose come la dilatazione della pupilla, la contrazione degli occhi o lo sbattimento delle palpebre.

Il brevetto in questione, tra l’altro, ricorda per molti versi quello sul “Pay-Per-Gaze” balzato agli onori delle cronache 3 anni fa, dove Google ipotizzava un sistema dove le pubblicità vengono pagate dall’inserzionista solo se effettivamente osservate dall’utente.

Anche in quel caso si diceva che “il sistema può dedurre uno o più stati emotivi dell’utente mentre visualizza l’elemento identificato all’interno della scena, sulla base delle informazioni di dilatazione della pupilla”. In parole povere: un title, una description o più in generale uno snippet che si “presenta bene” sullo schermo dello smartphone, potrebbero influenzare (positivamente o negativamente) l’utente che ha effettuato la query. Google potrebbe anche “ricordarsi” che quell’utente non gradisce un certo risultato, e quindi farlo scendere più un basso sulla SERP.

E potrebbe anche “estendere” questo sentiment ad altri utenti che effettuano la stessa ricerca sul motore. Siamo sempre nel campo delle ipotesi, ma se ci vogliono 3 indizi per fare una prova…