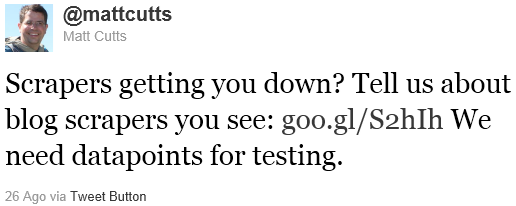

Dopo aver dichiarato guerra alle content farm a inizio anno, Google sposta ora l’attenzione verso gli scraper site, e in particolare verso i blog scraper (ovvero i blog che, in modo più o meno automatico, copiano i contenuti prodotti da altri siti). Lo fa a partire da questo tweet di Matt Cutts,

che in pratica dice più o meno così:

“Gli scraper fanno scendere il tuo sito? Comunicaci i blog scraper che trovi (nelle SERP): http://goo.gl/S2hIh Abbiamo bisogno di dati per fare dei test.” Il link presente nel tweet punta ad un modulo costruito con Google Doc, chiamato Report scraper pages. Il documento parte con una frase eloquente: “Google sta testando delle modifiche algoritmiche per gli scraper site (soprattutto per i blog scraper). Stiamo cercando degli esempi, e potremmo utilizzare i dati che ci sottoporrai per testare e migliorare i nostri algoritmi.”

All’interno della pagina è possibile inserire la query di Google che mostra dove gli scraper superano il contenuto originale, l’URL della pagina col contenuto originale e l’URL dello scraper.

Scraper Update vs. Panda Update

Per quanto si parli sempre e comunque di contenuti di pessima qualità, in Google c’è una distinzione fra Content Farm e Scraper, distinzione già emersa diversi mesi fa. Se ben ricordi, avevo infatti già parlato di uno Scraper Update – che avrebbe colpito gli Scraper a fine Gennaio 2011 – diverso dal Panda Update – mirato invece alle Content Farm. Lo stesso Matt Cutts, il 28 Gennaio disse che “le query sono variate in una percentuale leggermente superiore al 2%, ma le variazioni evidenti riguardano meno di mezzo punto percentuale. L’effetto finale è che gli utenti avranno una maggior possibilità di vedere siti con contenuto originale piuttosto che siti che copiano o “estraggono” i contenuti dai siti originali.”

In quell’occasione è assai probabile che Cutts stesse parlando dello Scraper Update (anche se nel suo post il cambiamento dell’algoritmo non viene “battezzato” con un nome), che evidentemente non è però riuscito nell’intento di eliminare dalle SERP tutti gli aggregatori e copiatori di scarsa qualità.

Concludendo

Google si vede costretto a chiedere un controllo umano per “aggiustare” i suoi algoritmi. Non è la prima volta e non sarà l’ultima, ed è sacrosanto utilizzare dei segnali umani per fare da cartina tornasole con quanto rilevato da un algoritmo; un esempio recente è l’estensione Personal Blocklist. Però mi chiedo: è possibile che, nel 2011, Google non riesca ancora a stabilire la paternità di un contenuto? è così difficile trovare il modo di taggare un contenuto come originale (e di conseguenza gli altri come copie)? è così problematico premiare chi passa ore ed ore a scrivere contenuti di qualità, e penalizzare invece chi copia questi contenuti in modo truffaldino?

UPDATE: il 27 Febbraio 2014, Matt Cutts ha nuovamente tweettato il link relativo allo Scraper Report. Preludio di un nuovo giro di vite nei confronti dei “ladri di contenuti“?