La dichiarazione di guerra agli Scraper Site ha mostrato – anche se non ce ne era bisogno – che Google ha serie difficoltà a riconoscere la fonte originale di un contenuto. Ad oggi si basa principalmente sull’autorevolezza/trust di un sito, che si crea in base ad un mix di anzianità, qualità/freschezza/numero dei contenuti, link in ingresso, fattori sociali e tanti altri piccoli segnali che Google legge e interpreta per stabilire qual è l’originale e quale la copia.

Questo modus operandi del motore di ricerca, spesso e volentieri, fa emergere dalle SERP siti che copiano/aggregano contenuti di terzi, siti che vengono però visti come più autorevoli della fonte originale e quindi vengono premiati a discapito di quest’ultima. In altre parole, se la prima sorgente di un contenuto non è autorevole agli occhi del motore, viene penalizzata quasi come fosse uno dei tanti “copioni” presenti su Internet – se questi copioni hanno un trust maggiore della fonte.

A questo nonsense totale, che deprime che scrive e riempie il web di spazzatura ridondante, credo che Google debba mettere fine con un provvedimento un po’ più drastico della “segnalazione volontaria” degli scraper.

Proposta per un algoritmo che riconosca i contenuti originali

Premessa

Non sono un analista, un programmatore o un ingegnere, non capisco una mazza di algoritmi e quanto scrivo è solo in base al mio (limitato) buon senso. La mia proposta è molto semplice, probabilmente già pensata da molti altri, e richiede il supporto di questi elementi:

• un CMS (o meglio un plugin sviluppato da Google per integrarsi al CMS)

• Google Webmaster Tools

• il Googlebot 🙂

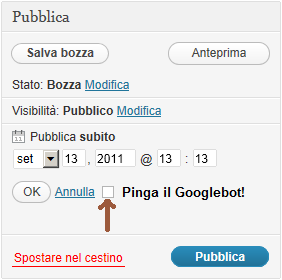

Partiamo dal CMS e dal plugin: personalmente, per un test iniziale, propenderei per WordPress, che a quanto pare è utilizzato dal 14,7% dei top million website del mondo e dal 22% dei nuovi domini attivati negli USA. Il plugin dovrebbe semplicemente far comparire un quadratino da flaggare all’atto della schedulazione del post, qualcosa di questo tipo:

In pratica, al termine della scrittura dell’articolo, mentre decido il giorno e l’ora di pubblicazione, invio a Google l’articolo reclamandone la partenità. Spuntando il quadratino sto dicendo a Google: “Ehi, questo articolo è mio, mettilo nella tua cache, e ricordati che è l’originale. Tutti gli altri che vedrai in giro sul web sono copie, e come tali andranno trattate ai fini del ranking.” Ovviamente Google confronta il contenuto con le altre pagine presenti nel suo database, e se questo è effettivamente originale lo cacha (inviando conferma all’autore).

Se il contenuto è copiato, parzialmente o integralmente, invia un alert al webmaster dicendogli: “Attenzione, il contenuto dell’articolo non è originale. Verrà indicizzato con priorità inferiore e posizionato almeno trenta risultati dopo il contenuto originale, oppure finirà nell’indice supplementare.” Fra gli elementi necessari a far funzionare il tutto ho citato anche gli Strumenti per i Webmaster di Google, nonché il Googlebot. Il primo sai benissimo come funziona: Google ha vari sistemi per verificare che tu sia il proprietario di un sito, e potrebbe utilizzare la stessa logica per accertare la paternità dei contenuti.

Per esempio, un codice univoco generato dagli Strumenti per i Webmaster di Google potrebbe essere inserito nel pannello di amministrazione del plugin, ed “impresso” sui singoli post come una sorta di filigrana: metà del codice potrebbe essere sempre uguale (ovvero quello relativo al sito), mentre l’altra metà potrebbe essere variabile (e quindi identificare il singolo post). Esempio: il sito X ha il codice QAZWSXEDC, che lo identifica univocamente in Google.

Ad ogni articolo pubblicato sul sito X viene appeso un codice con data e ora, più un altro pezzo randomico. Per esempio un articolo pubblicato oggi alle 13:13 conterrebbe 201109131313, più alcuni caratteri a caso (RFVTGBYHN), e quindi l’identificativo completo del post risulterebbe QAZWSXEDC-201109131313-RFVTGBYHN. Solo la pagina che include in un metatag (generato dal plugin) questo codice è considerata da Google la fonte originale, e se comunque la pagina viene integralmente copiata (sia nel contenuto che nel metatag) entra in gioco il controllo incrociato col nome a dominio, che penalizza gli eventuali copioni. Perché fra i 3 elementi ho inserito anche il Googlebot? Semplicemente perché servirà scatenarlo per fargli leggere “in anteprima” il contenuto.

Sappiamo che da qualche tempo lo spider è estremamente veloce, ma qui ci occorre un sistema che permetta al bot di cachare il contenuto prima che questo venga pubblicato: se sia possibile farlo tramite il plugin (passandogli login e password del CMS) o con altri metodi più sofisticati, lo lascio decidere ai tecnici.

Se fra i lettori c’è qualche esponente di Google, o qualcuno in grado di segnalare a chi dovere questo post, mi piacerebbe ricevere qualche parere autorevole 🙂